Mesterséges intelligenciával (AI) találkozunk mindenütt, a magánéletben és a munka világában egyaránt, és ma már aligha ütközik meg ezen bárki, akiben ez egyáltalán tudatosul. A technológia egyre újabb, egészen meglepő használati eseteire azonban naponta rácsodálkozhatunk, mondta Arató Bence, a BI Consulting ügyvezető igazgatója a Budapest ML Fórumon, a cég első alkalommal megrendezett, kimondottan gépi tanulásra (machine learning) és adattudományra (data science) szakosodott online konferenciáján.

Két startup, az Authentic Artists és az Alyce példájával illusztrálta előadásában az ügyvezető, hogy a lehetőségek messze túlmutatnak az ügyfélszolgálati csevegőrobotok készítésén vagy az ügyfélkör szegmentálásán dolgozó marketingesek támogatásán. Előbbi vállalat virtuális zenészeket, lemezlovasokat fejleszt, "akik" a tervek szerint emberi előadóművészek társaságában lépnek majd porondra. Az Alyce pedig egészen eredeti réspiacot fedezett fel magának, mivel a céges ajándékozás olykor nyűgös feladatát teszi könnyebbé AI-támogatással.

Ömlik a pénz

A kockázati tőke ennek megfelelően ömlik a mesterséges intelligenciára és gépi tanulásra építő startup cégekbe. Az Alyce eredeti megoldása például 30 millió dollár befektetői bizalmat gerjesztett. A Statista legfrissebb összesítése szerint az AI-startupokba áramló befektetések a múlt év első felében a 16 milliárd dollárt közelítették: 2020 első negyedében 8,5, a másodikban pedig mintegy 7,2 milliárd dollárra rúgtak világszinten. Idén márciusban egyedül a Feedzai mesterséges intelligenciára építő fintech startup 200 millió dollárt vonzott, de ebben a hónapban további nyolc feltörekvő AI-cég egyenként 10-70 millió dolláros tőkeinjekciójáról röppent fel hír.

Más szóval az AI/ML-szektor szépreményű szereplői havonta tucatszám kapnak több tíz- vagy százmilliós befektetést, és a pénz beáramlása a Statista szerint a 2017-es ugrás (éves szinten 17,8 milliárd dollár) óta mind nagyobb méretet ölt. Tükrözik ezt a cégfelvásárlások is, a CB Insights idősoros áttekintése szerint a milliárd dollárnál nagyobb értékű akvizíciók száma 2018 óta gyorsan nő, tavaly már hat ilyen exitet is tető alá hoztak a felek. Gyakran a nagy technológiai cégek, például az Amazon, az Apple, a Facebook, a Google és a Microsoft vásárolnak - tavaly mindegyikük vett legalább egy AI céget -, amelyek eleve AI, ML és data science szakemberek százait, ezreit foglalkoztatják. A Microsoft például idén áprilisban, napokkal a konferencia előtt fizetett 19,7 milliárd dollárt az egészségügyre optimalizált beszédfelismerő technológiájáról ismert Nuance-ért, így ez lett eddigi második legnagyobb akvizíciója.

Mindez ismételten a fejlődés száguldó tempójára, valamint arra hívja fel figyelmünket, hogy a szállítók, szolgáltatók milyen hatalmas jelentőséget tulajdonítanak az elég nehezen különválasztható mesterséges intelligenciának és gépi tanulásnak.

Alternatívák feldolgozásra

A mesterséges intelligencia már ma is elképesztő teljesítményre képes, és napról napra okosabb, az igazán versenyképes AI-modellek tanítása azonban rendkívül adatintenzív és erőforrás-igényes feladat. Az OpenAI adatai szerint az AI-rendszerek tanítására fordított napok száma - ha másodpercenként 1 petaflops feldolgozási teljesítményt veszünk alapul - 3,4 havonta megduplázódik. Komoly kérdéseket vet fel ez egyrészt az ilyen munkaterheléseket futtató rendszerek energiafogyasztását és szénlábnyomát, másrészt a versenyt korlátozó hatását tekintve, mondta Arató Bence. A mind jobb AI-modellek gyorsabb tanításához szükséges költségeket ugyanis egyre kevesebb szervezet engedheti meg magának.

Szerencsére a hardvergyártók nem nézik tétlenül ezt a trendet, és egyre újabb célprocesszorokkal lépnek piacra, amelyek alacsonyabb energiafogyasztás mellett nagyobb teljesítményt adnak az AI-modellek tanításához. Úgy tűnik, ezek az alternatív feldolgozó egységek még Moore törvényét is felülírják, amely szerint a CPU-k teljesítménye 24 havonta duplázódott meg, azaz évente mintegy 40 százalékkal nőtt. De míg ez a tempó mára 30 százalék körülire lassult, addig az arc- és beszédfelismeréshez, valamint más mesterségesintelligencia-alkalmazásokhoz használt SoC-ok (egylapkás rendszerek) teljesítménye évente több mint 100 százalékkal nő.

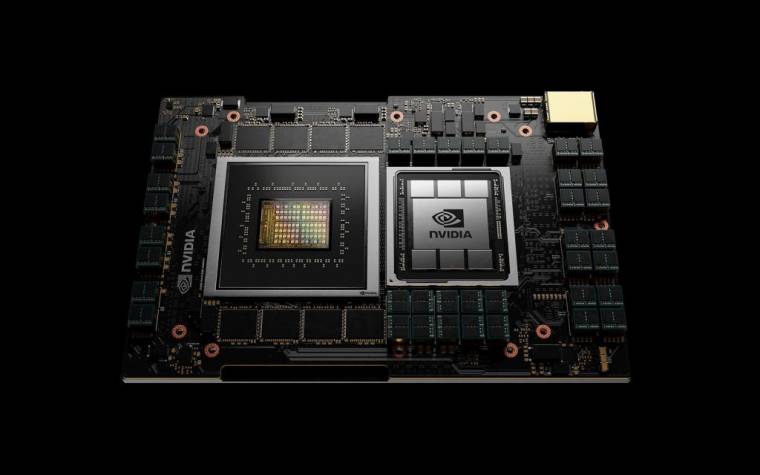

Az NVIDIA áprilisban jelentette be első adatközponti processzorát, a Grace-t, és azt ígéri, hogy az Arm processzormagokat tartalmazó feldolgozó egység tízszeres teljesítményt fog adni a legnagyobb és legösszetettebb AI- és HPC-munkaterhelések futtatásához.

Kétmilliárd dollár körüli áron vásárolta fel az Intel 2019 decemberében az izraeli Habana Labs nevű céget, amely a programozható mélytanuláshoz készít gyorsítókat. Az Amazon Web Services EC2 virtuális szerverei az idei év kezdetétől a Habana legfeljebb nyolc darab Gaudi gyorsítójával konfigurálva ár és teljesítmény akár 40 százalékkal jobb arányát kínálják a - többek között gépi látáshoz és természetes nyelvi feldolgozáshoz használt - nagy AI-modellek tanításához, jelentette be a felhőszolgáltató. A Habana másik célprocesszora a Goya, amely a tanított modelleket futtató, aktuális adatokból következtető AI-rendszerek teljesítményét és hatékonyságát fokozza.

Felhőjében, saját TPU processzorain a Google is kínál az AWS EC2-Gaudi pároshoz hasonló megoldást, a Microsoft Azure pedig a Graphcore IPU-jaival gyorsítja a gépi tanulást. Az Intel becslése szerint egyébként az AI-szilícium piaca 2024-re 25 milliárd dollár fölé fog nőni, és ennek több mint 10 milliárd dolláros szelete az adatközpontokba szánt speciális processzoroké lesz.

Szintetikus adatok, valódi veszélyek

A mégoly különleges hardver azonban csupán félkarú óriás lenne szoftver nélkül. A Gartner friss mágikus négyzete (2021 Magic Quadrant for Data Science and Machine Learning Platforms) jól tükrözi, hogy a vállalati data science- és ML-platformok piacán egyrészt bővül a szállítók mezőnye, másrészt a szereplők folyamatosan helyezkednek. Arató Bence kiemelte, hogy az elemző által piacvezetők közé sorolt SAS és IBM platform valamelyike a hazai felhasználói tábort alkotó nagyvállalatok szinte mindegyikénél megtalálható, jellemzően további, nyílt forráskódú szoftverek társaságában. A nagy AI/ML-fejlesztő hármas, az AWS, a Google és a Microsoft vállalati platformját a Gartner a jövőbe mutató, ígéretes megoldások között tartja számon, a réspiaci szereplők között pedig olyan szállítók jönnek fel, mint a Cloudera vagy a felénk ebben a minőségében még kevéssé ismert Alibaba és Samsung.

Minthogy a gépi tanulás költségterheinek enyhítésére a vállalatok egyre inkább a nyilvános felhőben keresnek megoldást, a szolgáltatók nemcsak hardvererőforrásokat, hanem kész AI-modelleket is kínálnak nyílt API-kon keresztül. Ilyen többek között a tavaly nyáron bejelentett GPT-3, az OpenAI harmadik generációs autoregresszív nyelvi modellje, amely az emberi írás minőségét idéző szöveges tartalmat állít elő. A GPT-3 kapacitása tízszer akkora (175 milliárd ML-paraméter), mint a korábbi legnagyobb modellé, a Microsoft által jegyzett Turing NLG-é volt. A redmondiak tavaly szeptemberben kizárólagos használatra licencelték is a GPT-3-at, de ez a forráskódhoz ad exkluzív hozzáférést, a modell nyílt API-n keresztül továbbra is elérhető.

Izgalmas feljövő terület az MLOps, amelynek startup-szereplői az AI-modellek vállalati felhasználásához, éles működtetéséhez és monitorozásához adnak többnyire nyílt forráskódú eszközöket. Minthogy a gépi tanulás szélesebb térhódítását a modellek tanításához szükséges nagy adatmennyiség hiánya is hátráltathatja, a szállítók egy másik csoportja szintetikus adatokkal igyekszik demokratizálni, hozzáférhetőbbé tenni a mesterséges intelligenciát, illetve segíteni a modellek tanítását, ha a vállalat a törvényi megfelelés miatt meglévő adatait nem használhatja erre a célra. Egészen új terület ez is, de hamar megmozgatta a befektetők képzeletét, a startupok több millió dolláros tőkeinjekciókat kapnak, mondta Arató Bence. Felhívta ugyanakkor a figyelmet arra, hogy a szintetikus adatok nagyon is valódi hibákhoz vezethetnek.

A MIT kutatói márciusban tették közzé például, hogy az ML-kutatásokban leggyakrabban használt 10 tesztadatkészletben 3,4 százalékos átlagos címkézési hibaarányt állapítottak meg. A mesterséges intelligenciát többek között elfogulttá tevő tévesztések aránya azonban a QuickDraw tesztadatkészletben elérte a 10 százalékot.

Cikkünk a Computerworld 2021/8. számában, április 28-án jelent meg